| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 3d 뷰어

- 배경모델링

- 3D

- 3ds Max

- 모작

- 메가스캔 유료화

- 재질

- 셰이더그래프

- 레퍼런스 프로그램

- rodin ai

- 모델링 ai

- 유니티

- 스무딩그룹

- 게임개발

- 프로젝트

- normal map

- UE5

- 메가스캔

- fbx 안열림

- 3d 모델링 ai

- 노말맵깨짐

- 게임제작

- 엔진심화

- 공부

- fbx

- 게임그래픽

- 방학셰이더스터디

- fbx 보안

- 노말맵

- 3d 모델을 로드할 수 없음

- Today

- Total

베개발

AI 뎁스맵 실험(삽질) 본문

https://www.youtube.com/watch?v=LNfph71v4m8

ZDepth plugin for Zbrush

Model AI ZDepth- FastFastest mode, using a lightweight AI model.Produces basic depth results — ideal for quick tests or preview.- MediumBalanced between speed and quality.Generates a more detailed depth map compared to Fast.- HighUses a heavier AI model

zmpolygon.gumroad.com

ZDepth plugin for Zbrush 라는 플러그인을 봤는데

뎁스맵 생성에 AI 모델을 쓴다고 한다. 뭘 쓰는 거지?

그러고보니 뎁스맵 AI가 (lora 말고) 있었던 것 같은데.. 하고 찾아보니 marigold라는게 있었다.

https://github.com/kijai/ComfyUI-Marigold?tab=readme-ov-file

GitHub - kijai/ComfyUI-Marigold: Marigold depth estimation in ComfyUI

Marigold depth estimation in ComfyUI. Contribute to kijai/ComfyUI-Marigold development by creating an account on GitHub.

github.com

플러그인 구매 전에, 이걸로 되는지 한번 실험하고 싶어져서 (그리고 직접 만들어보고 싶기도 해서)

comfyui에 custom node 폴더랑 모델 폴더에 git clone을 해서 받아줬다. 모델은 git lfs로 받아야 되는 것 같았다

명령어가 git lfs pull 이던데 깃 링크는 어떻게 알고 받았을까 하니

.git 폴더 안에 config라는 파일 안에 다 들어있었다

뭐 연구? 공부? 하다보면 이런 잡생각들과 호기심이 너무 많이 생겨서 문제다 (ㅋㅋ)

열심히 받는중

기다리는 중에 무려 marigold 논문이 올라온 블로그를 찾았다

https://kimjy99.github.io/%EB%85%BC%EB%AC%B8%EB%A6%AC%EB%B7%B0/marigold/

[논문리뷰] Repurposing Diffusion-Based Image Generators for Monocular Depth Estimation (Marigold)

Marigold 논문 리뷰 (CVPR 2024 Oral)

kimjy99.github.io

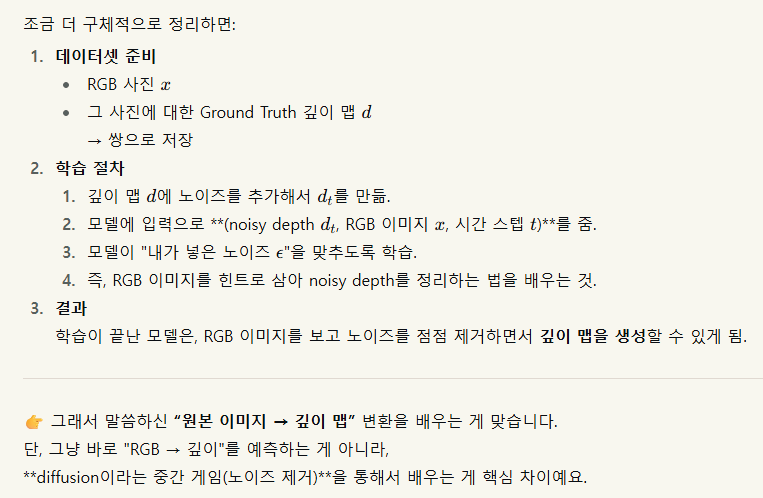

수식 이런건 하나도 모르지만

대충 원본 이미지와 뎁스맵을 쌍으로 넣어서 학습을 시키면 저렇게 된다나보다

스테이블 디퓨전의 디퓨전이 저건가 보다...

다운받던 도중 뭔지 모를 오류로 인해

폴더삭제와 config.json 파일 손수 하나하나 받기 등등... 삽질을 통해서

드디어 구동에 성공했다!!

워크플로우는 example 파일 안에 들어있던 예시 워크플로우를 사용했다.

테스트용 원본 짤과 생성된 뎁스맵.

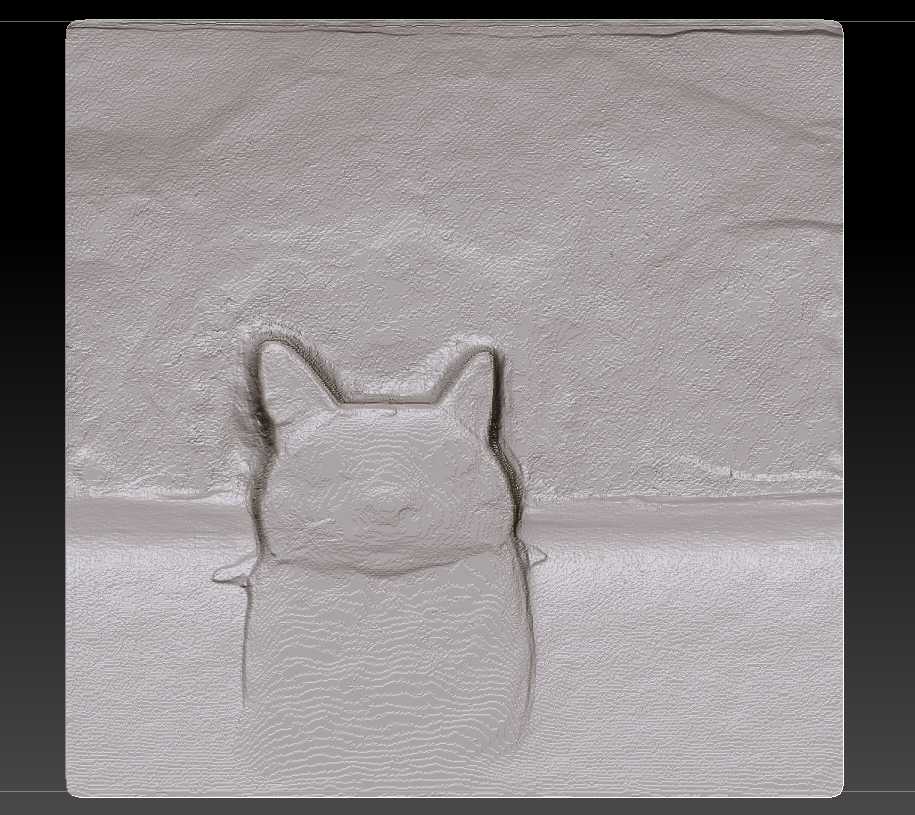

지브러쉬에 가져가서 찍어보니

이렇게 나온다.

사진이 너무 대충 넣은거라 애매한데 나름 코랑 눈 위치도 다 보인다.

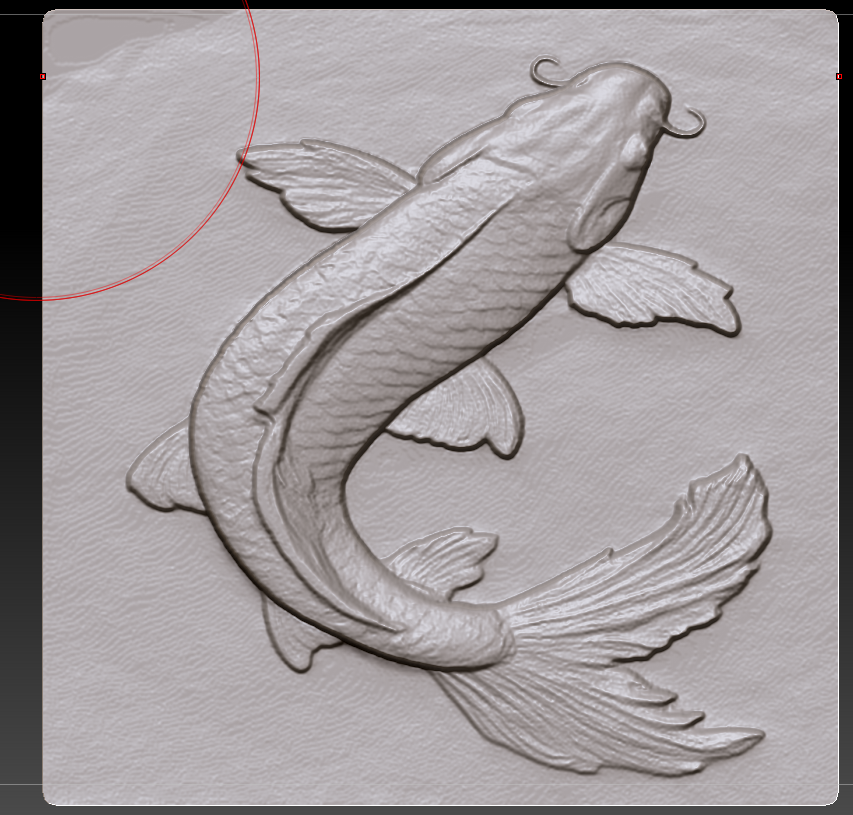

다음으론 좀 제대로 된 이미지를 넣어봤다.

gemini가 잘못 뽑아준 사진이다... 그림자를 지워달라 했는데 계속 그대로 주길래

너 그림자가 뭔지는 아냐고 물어봤는데

사과하면서 또 똑같은 사진을 줬다 ㅜㅜ

아무튼 그대로 넣어봤는데, 신기하게도 그림자 제외한 진짜 순수 뎁스맵만 그대로 나왔다

지브러쉬에서 보면 이렇게 된다. 오...

이끼 부분이 좀 아쉽지만 그래도 괜찮은 것 같다

딱 양각/음각 무늬넣을때 좋아보인다.

다음엔 실사용 가능해보이는 이미지를 핀터레스트에서 주워온 뒤 넣어봤다.

이게 되네?

됐다. 진짜 되네?

지브러쉬 안에서 텍스쳐와 displacement map 둘다 적용해주면 이런 느낌. 디포메이션에서 contrast도 좀 높여줬다.

근데 좀 이상하게 나오는 이미지도 있다. 안쪽이 뚫려있는 걸로 나온듯 한데 왜지..?

시드 문제인 것 같아서 MarigoldDepthEstimation 노드에 시드를 randomize로 바꿨는데

그렇게 큰 차이는 없어보였다.

다른 이미지들도 마찬가지로, 시드에 따른 결과물 차이는 눈에 띄지 않는다

좀 기울어진 걸로 인식하는 경우도 있었고.. (뭐가 문젤까?)

재밌어서 여러가지 넣어봤다.

3d 프린터로 뽑은것마냥 중간중간 층이 지는건

아마 png라서 단계별로 1씩 차이가 날수밖에 없어 그런듯 하다. 그럼 총 256단계인가?

직접 polish나 smooth 해주면 해결되는 문제긴 하다

이미지가 정사각형으로 찌그러지는 이유는

ai가 정사각형 이미지 (특히 768*768)에 강하다고 해서

워크플로우 자체에 이미 이미지 리사이즈 노드가 들어가 있기 때문이다.

너무 재밌어...

플러그인 영상을 보니 다른 기능들도 많아보였다.

영상 설명에는 업스케일 ai를 별도 링크로 소개해주던데

업스케일 ai도 잘하면 플러그인 안에 그냥 넣을 수 있지 않을까...

나중에 플러그인을 써보게 되면

꼭 뜯어서 지브러쉬 플러그인은 어떻게 만드는지 구경하고 싶다.

hunyuan 3d 로컬에서 돌리는거 저번에 성공했었는데

잘만하면 그것도 그냥 플러그인으로 만들어버릴 수 있지 않을까.. 혼자 쓰는 용으로

'3D > 공부 메모' 카테고리의 다른 글

| 의식의 흐름) AI를 3D작업에 어떻게 활용할 수 있을까 (15) | 2025.08.17 |

|---|---|

| highpass 관련 메모 (7) | 2025.05.25 |

| 자료번역) Plant modeling for video games (1) | 2025.05.04 |

| 맥스에서 버텍스 사라짐 / 버텍스 없이 엣지만 보일때 해결법 (3ds max) (0) | 2025.04.08 |

| 맥스파일 다른 버전으로 저장하는 법 (3ds max) (0) | 2025.04.08 |